2025年6月30日,華為正式宣布開源盤古7B參數的稠密模型、盤古Pro MoE 72B混合專家模型和基于昇騰的模型推理技術。

華為稱,此舉是華為踐行昇騰生態戰略的又一關鍵舉措,推動大模型技術的研究與創新發展,加速推進人工智能在千行百業的應用與價值創造。

目前,盤古Pro MoE 72B模型權重、基礎推理代碼,已正式上線開源平臺;基于昇騰的超大規模MoE模型推理代碼,已正式上線開源平臺;盤古7B相關模型權重與推理代碼將于近期上線開源平臺。

根據華為此前公布的信息顯示,盤古7B模型為雙系統框架,具備“快思慢想”功能,能夠根據任務復雜度自動選擇合適的模式,即在常規請求下使用“快思考”模式,在復雜推理任務下使用“慢思考”模式,從而在延遲和推理深度之間實現平衡。在多款復雜推理測試中,盤古7B的性能要強于阿里巴巴旗下的Qwen3-8B、智譜旗下的GLM4-9B,

盤古Pro MoE 72B混合專家模型參數量為720億,在激活160億參數量的情況下,通過動態激活專家網絡的創新設計,實現了以小打大的優異性能,甚至可以媲美千億級模型的性能表現。華為聲稱,該模型針對昇騰300I Duo、800I A2平臺進行優化,在后者上可以實現單卡1148 token/s的推理速度。

在業界權威大模型榜單SuperCLUE中文大模型基準測評5月的數據,盤古72B在開源排行榜中位列第五,總分為58.75分,超越Qwen3-14B、Qwen3-8B,僅次于DeepSeek-R1滿血版、DeepSeek-V3滿血版以及Qwen3-32B和235B。

值得一提的是,盤古72B的文本理解與創作得分位居榜單之首,為80.48分,但在科學推理能力上僅有39.6分,明顯弱于位居榜單前列的其余模型。

華為專家曾表示,“盤古72B是兼顧性能與推理成本的黃金尺寸,最適合行業用戶用AI改造業務。”

除了前述兩款模型,華為近期還推出了參數規模達7180億新模型——盤古Ultra MoE,全流程在昇騰AI計算平臺上訓練。華為同時發布盤古Ultra MoE模型架構和訓練方法的技術報告,披露眾多技術細節。

據華為技術專家介紹,華為盤古718B Ultra MoE萬卡集群預訓練MFU(模型算力利用率)達到41%,實驗室已達到45%;CloudMatrix384超節點訓練MoE大模型,MFU超過50%。

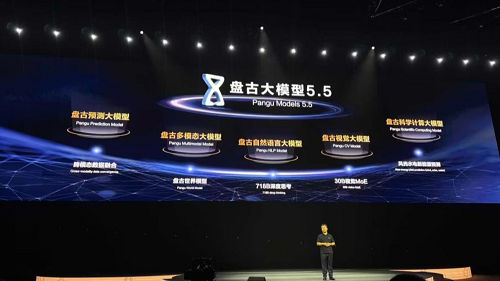

值得一提的是,近期在華為開發者大會(HDC 2025)上,華為云還發布了盤古大模型5.5,對自然語言處理(NLP)、計算機視覺(CV)、多模態、預測、科學計算五大基礎模型進行升級。同時,基于CloudMatrix 384超節點的新一代昇騰AI云服務全面上線。